Hüseyn Şəhid

__________________________________

Keçmişdə insanlar bəşər sivilizasiyasında inqilab edən şeylər icad etdikdə, geniş ictimaiyyət yavaş-yavaş biləcək və onlara çatmaq üçün illər lazım olacaq. Məsələn, bəşər sivilizasiyasını dəyişdirən elektrik, təəssüf ki, hələ də Yer kürəsinin bəzi ucqar yerlərinə çatmayıb.

Bununla belə, qlobal əlaqə bugünkü dünyanı dəyişdi və bu, süni intellekt inqilabının son istifadəçilərə od kimi yayılmasına səbəb oldu. Süni intellekt öz üstünlüklərini gətirsə də, dünya indi görünməmiş problemlərlə üzləşir. Bu əlaqəli risklərin başa düşülməsi və azaldılmasının aktuallığını şişirtmək olmaz, çünki bizim hərəkətə keçmək üçün bufer vaxtı yoxdur.

AI-nin həyatımızın və işimizin hər tərəfinə təsir etmək potensialı böyükdür. Bununla belə, miqyasını nəzərə alsaq, onun həssas şəxslər, KOM-lar və inkişaf etməkdə olan iqtisadiyyatlar üçün yaratdığı risklər fəlakətdən başqa bir şey ola bilməz.

Ən aktual problem iş sektorlarındadır, çünki maşınlar kodlaşdırma, müştəri dəstəyi və məzmun yaradılması kimi təkrarlanan vəzifələri öz üzərinə götürməyə hazırdır. Məlumatların məxfiliyi, dərin saxtakarlıq və təhlükəsizlik məsələləri də eyni dərəcədə narahatlıq doğurur. Qlobal birlik innovasiya və etika arasında incə balans yaratmaq üçün qaydaların tətbiqini sürətləndirməlidir.

Aydın olmaq üçün, pis olan süni intellekt deyil; biz insanlar bu alətdən həm yaxşı, həm də şər üçün istifadə edə bilərik. Keçmişdə insanlar sarsıntılı davranış nümayiş etdirdiklərinə görə, riskləri azaltmaq üçün yoxlamalar və tarazlıqlar qoymaq daha yaxşıdır.

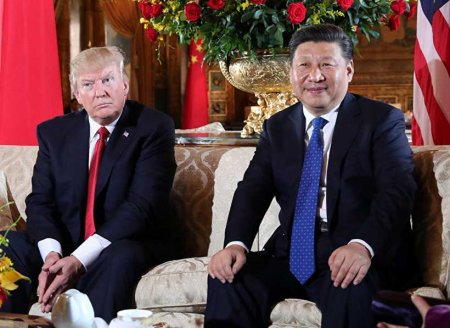

Aİ-nin AI Aktı bu istiqamətdə ilk addım idi və ümid edirəm ki, Çin və ABŞ süni intellekt və etikanın incə balansını qorumaq üçün daha çox işlər görəcəklər. Zamanın tələbi süni intellekt inqilabını iki ölçüdə bölməkdir: hamı üçün süni intellekt, yəni süni intellektin faydası tək bir şirkətin və ya ölkənin inhisarında olmamalıdır və AI risklərindən qorunmaq üçün Qlobal Tənzimləmə.

Bütün dünyanın nəyisə razı salması adi hal deyil, lakin iqlim dəyişikliyi kimi, süni intellekt də qlobal qaydalara malik olmalıdır, burada güc mərkəzləri süni intellektni hamı üçün faydalı etmək və cəmiyyəti onun dalğalanma təsirlərindən qorumaq məsuliyyətini öz üzərinə götürür.

Yaxşı xəbər budur ki, Məsul AI haqqında söhbətlər var və bəzi hökumətlər daxili siyasət aparır. İnşallah, Birləşmiş Millətlər Təşkilatında bununla bağlı daha çox müzakirələrin şahidi olacağıq.

Həmçinin, süni intellekt texnologiyasının hələ də inkişaf etdiyini başa düşmək vacibdir, ona görə də tənzimləyicilərin çoxillik yanaşması vacibdir. Bu, onlara riskləri azaltmaqla yanaşı, innovasiyaları boğmamağa imkan verəcək.

Şirkətlər süni intellektə öyrətmək üçün adi insanların məlumatlarından istifadə edir və tənqidçilər insanlar üçün təhlükəli ola biləcək super AI kimi başa düşülə bilən AGI-ni proqnozlaşdırırlar. İndi sual yaranır: Əgər ümumi ictimai məlumatlardan istifadə edilərsə və şirkətlər potensial olaraq milyardlar qazanarsa, onlara səhmlər kimi pul faydaları vermək ədalətli olmazdımı? Bu, həm istifadəçilər, həm də şirkətlər üçün məlumatların istifadəsini və məxfiliyi ön plana çıxaracaq.

Siyasətçilər bütün maraqlı tərəflər üçün platforma təmin etməlidirlər ki, bu platforma təkcə güzəştə məruz qalmış Texnologiya şirkətləri deyil, həm də dəyərli fikirlər verə bilən Akademik Alimlər, texnoloji müzakirələrdə tez-tez az təmsil olunan qadınlar və qeyri-texnoloji şirkətlər kimi digər maraqlı tərəflər olmalıdır. AI xidmətlərindən ən çox təsirlənənlər ola bilər. Süni intellektin tənzimlənməsi prosesində onların narahatlıqlarına böyük əhəmiyyət verilməlidir. Fərqli ölkələrin süni intellektini hamı üçün faydalı etmək üçün vahid platformaya çıxa bilməyəcəkləri və ya inhisarçılıq üçün bir-biri ilə rəqabət aparacaqlarından asılı olacaq. Texnologiya şirkətləri iş görmək üçün buradadırlar və biznesin ən kritik tərəfi mənfəətdir ki, bu da bəzən cəmiyyətə görünməmiş problemlər gətirə biləcək qərarlarla birləşir. Buna görə də, ən azı Məsul AI haqqında danışmağa başlamaq və onun dalğalanma təsirlərindən qorunmaq üçün qlobal uyğunluğa təkan vermək çox vacibdir.

Azeri Light" markalı Azərbaycan neftinin 1 barelinin qiyməti 0,51 ABŞ dolları, yaxud 0,68 % azalaraq 74,17 ABŞ dolları təşkil edib.

Azeri Light" markalı Azərbaycan neftinin 1 barelinin qiyməti 0,51 ABŞ dolları, yaxud 0,68 % azalaraq 74,17 ABŞ dolları təşkil edib.

Londonda Xəzər Siyasət Mərkəzinin Trans-Xəzər bağlantısına dair üçüncü London konfransı keçirilib

Londonda Xəzər Siyasət Mərkəzinin Trans-Xəzər bağlantısına dair üçüncü London konfransı keçirilib

General-mayor Nurullah Muradxanlı:Vətən uğrunda yaşayan insan yaxud ruhunda əbədi vətən sevgisi gəzdirən şərəfli ömür sahibi

General-mayor Nurullah Muradxanlı:Vətən uğrunda yaşayan insan yaxud ruhunda əbədi vətən sevgisi gəzdirən şərəfli ömür sahibi

Malayziya- Azərbaycan:qida emalı və istehsal sektorları sahəsində inkişaf edən bazar strategiyası

Malayziya- Azərbaycan:qida emalı və istehsal sektorları sahəsində inkişaf edən bazar strategiyası

Qlobal Təhsil Sistemnin dağılan(dağıdılan) Arxitekturası

Qlobal Təhsil Sistemnin dağılan(dağıdılan) Arxitekturası

Qlobal maliyyə və geosiyasi sabitliyin laxlayan sütunu,- ABŞ-Çin münasibətləri fonunda

Qlobal maliyyə və geosiyasi sabitliyin laxlayan sütunu,- ABŞ-Çin münasibətləri fonunda

Siyasi-hərbi münaqişələrdə güc asimetriyalarının dizbalansı

Siyasi-hərbi münaqişələrdə güc asimetriyalarının dizbalansı

Zəngəzur dəhlizi ilə bağlı razılaşma əldə olundu - Məxfi planla bağlı ŞOK DETAL

Zəngəzur dəhlizi ilə bağlı razılaşma əldə olundu - Məxfi planla bağlı ŞOK DETAL